动作识别是计算机视觉中的主要任务之一,视频是一种随时间变化的连续图像序列,因此视频动作识别比图像动作识别难度更大、更富有挑战性。我司“孔雀团队”王文敏教授研究小组在该领域的研究取得了重要进展,其研究成果发表在2016年12月上旬召开的机器学习与计算神经科学的顶级国际会议Neural Information Processing System (NIPS) 上。

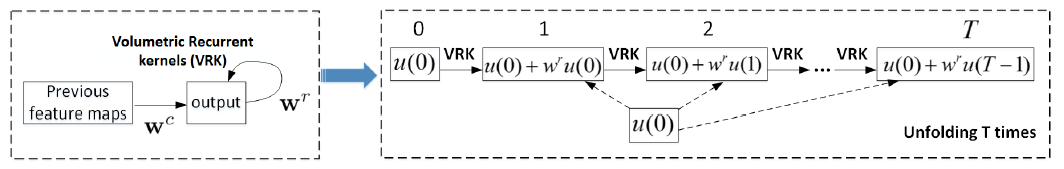

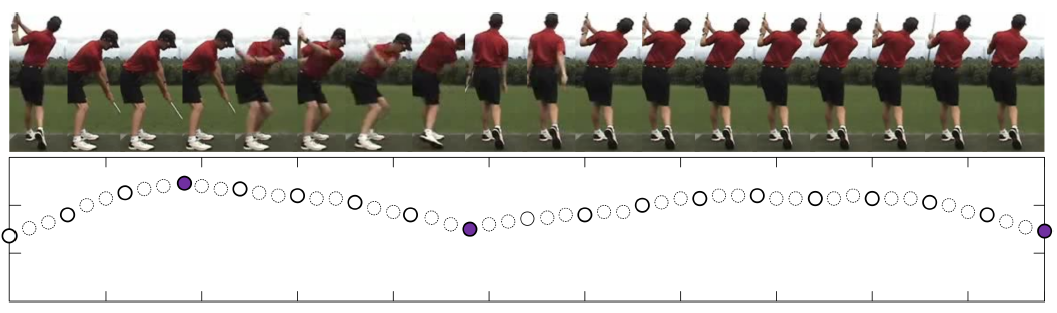

该成果的主要贡献如下:首先,针对视频的时空特性,提出了深度交替神经网络(DANN: Deep Alternative Neural Network),DANN结合卷积神经网络CNN与循环神经网络RNN的优势,在每个卷积层后增加一个特殊设计的循环层。相对于已有的深度网络,DANN交替层的特殊处理可利用较少的层数提取较丰富的低层局部特征的上下文信息;其次,针对不同尺度的视频数据,设计了自适应的视频片段分割策略,解决了现有方法使用预定义的长度、容易破坏视频自身的场景和语义分段的问题;第三,提出了一个全新的时空金字塔池化层,可将不同尺寸的视频所产生的不同尺度的特征图归一为统一的维度,从而解决了全连接层需要固定尺寸特征图的难点。

在上述三个学术贡献的基础上,设计并利用深度学习框架Torch实现了一个高效的视频动作识别系统,在两个主流的视频公共数据集上取得了相近或超过当前最优性能的表现,验证了所提出方法对视频中的动作识别、尤其是相似动作识别的有效性。

论文的第一作者是直博生王劲卓,通讯作者是王文敏教授,研究工作获得深圳市孔雀团队“图像与视频处理技术”项目资助,在十大网赌正规信誉网址独立完成。

这次NIPS 2016共接收论文568篇,国内学者的论文占接收论文的百分之一余,学术成果多数是与国外著名大学或著名研究机构合作完成,独立完成的相对较少。

Jinzhuo Wang, Wenmin Wang, Xiongtao Chen, Ronggang Wang and Wen Gao. “Deep Alternative Neural Network: Exploring Contexts as Early as Possible for Action Recognition”, the Thirty-first Annual Conference on Neural Information Processing Systems (NIPS). Dec. 5-10, 2016, Barcelona, Spain.

发布时间:2016-12-27

发布时间:2016-12-27 浏览次数:

浏览次数: